Évolution des méthodes de recherche UX pour les Agents d'IA dans la collaboration d'entreprise

\ Le changement s'est produit plus rapidement que quiconque ne l'avait prédit. Un jour, l'IA complétait automatiquement nos phrases. Le lendemain, elle participait à nos réunions, résumait nos conversations et rédigeait des messages de suivi en notre nom. Maintenant, elle prend des décisions.

J'ai passé des années à étudier comment les équipes collaborent via des plateformes intelligentes, et ce dont je suis témoin aujourd'hui représente la transformation la plus significative dans la dynamique du lieu de travail depuis l'introduction de l'e-mail. Les Agents d'IA ne sont plus des outils que nous utilisons. Ce sont des participants avec lesquels nous travaillons.

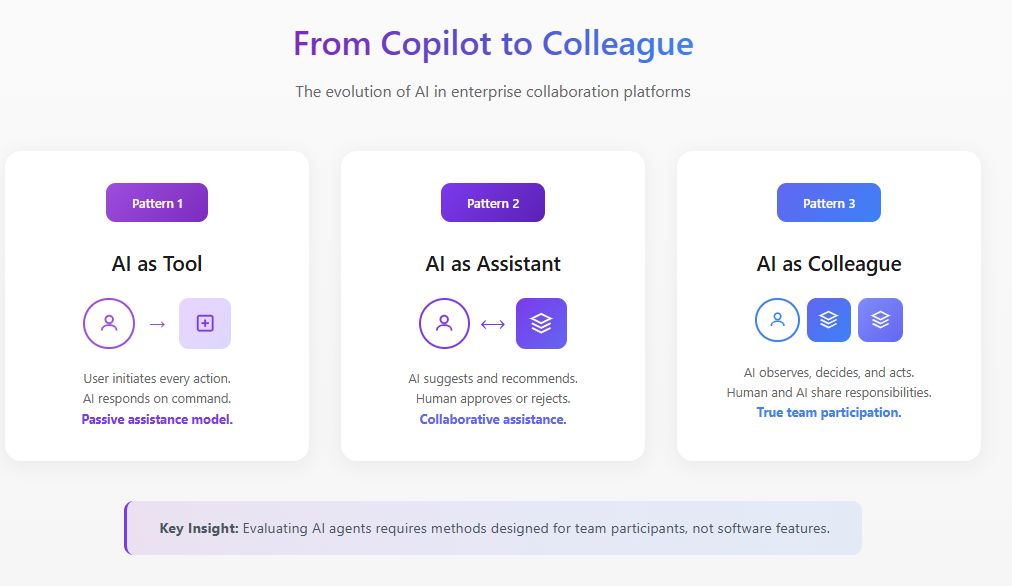

Cette distinction est extrêmement importante pour les chercheurs en expérience utilisateur. Les méthodes que nous avons développées pour évaluer les fonctionnalités des logiciels ne s'appliquent tout simplement pas lorsque ce logiciel commence à se comporter comme un membre de l'équipe.

Le changement fondamental : de la fonctionnalité au participant

La recherche UX traditionnelle pose des questions comme : Cette fonctionnalité est-elle facile à découvrir ? L'interaction est-elle intuitive ? Réduit-elle les frictions dans le flux de travail ?

Ces questions supposent que l'IA est passive, attendant l'entrée de l'utilisateur avant de répondre. Mais les Agents d'IA fonctionnent différemment. Ils observent, interprètent, décident et agissent. Selon les recherches de 2025 du MIT Sloan Management Review et du Boston Consulting Group, 35% des organisations ont déjà commencé à utiliser l'IA agentique, et 44% supplémentaires prévoient de l'adopter bientôt. Pourtant, 47% indiquent qu'elles n'ont aucune stratégie pour ce qu'elles vont faire avec l'IA. C'est précisément dans cet écart entre l'adoption et la compréhension que la recherche UX doit intervenir.

Lorsqu'un Agent d'IA rejoint une plateforme de collaboration, il modifie la dynamique sociale de l'équipe. Il affecte qui parle, quand ils parlent et ce qu'ils se sentent à l'aise de dire. L'évaluation de ces changements nécessite des méthodes qui vont bien au-delà des tests d'utilisabilité.

\

L'évaluation de l'IA pour les plateformes de collaboration d'entreprise

Dans mon travail de direction de la recherche UX pour les plateformes de collaboration intelligentes, j'ai développé des cadres d'évaluation spécifiquement conçus pour les Agents d'IA opérant dans des environnements d'entreprise. Ce travail se situe à l'intersection de la stratégie produit, du développement de l'IA et de la recherche sur les facteurs humains.

L'évaluation de l'IA dans ce contexte est fondamentalement différente de l'analyse comparative traditionnelle des modèles. Lorsqu'un Agent d'IA opère au sein d'une plateforme de collaboration, nous ne pouvons pas simplement mesurer la précision ou la qualité des réponses de manière isolée. Nous devons évaluer comment l'agent fonctionne dans la dynamique sociale et opérationnelle complexe des équipes réelles.

J'aborde les évaluations de l'IA pour la collaboration d'entreprise à travers trois couches interconnectées. La première couche examine la performance fonctionnelle : l'agent identifie-t-il correctement les éléments d'action, résume-t-il les discussions avec précision et présente-t-il les informations pertinentes aux moments appropriés ? La deuxième couche évalue la qualité de l'intégration : comment l'agent fonctionne-t-il de manière transparente dans les flux de travail existants sans créer de friction ou nécessiter des changements de comportement de la part des utilisateurs ? La troisième couche, et celle qui est le plus souvent négligée, évalue l'impact systémique : comment la présence de l'agent affecte-t-elle la dynamique d'équipe, la qualité des décisions et l'efficacité collaborative au fil du temps ?

Les recherches de la Harvard Business Review de mai 2025 décrivent les Agents d'IA comme des "coéquipiers numériques" représentant une catégorie émergente de talents. Ce cadrage exige que nous évaluions les Agents d'IA non seulement sur l'achèvement des tâches, mais aussi sur leur efficacité en tant que participants à l'équipe. Mes protocoles d'évaluation intègrent l'observation comportementale, le suivi longitudinal et l'analyse des résultats que les références traditionnelles de l'IA manquent complètement.

Les organisations qui obtiennent les résultats les plus solides sont celles qui intègrent directement la recherche UX dans leurs cycles d'évaluation de l'IA, en utilisant des métriques centrées sur l'humain parallèlement aux mesures de performance technique.

\

Construire des Agents d'IA hyper-personnalisés grâce à la recherche UX stratégique

La prochaine frontière pour les plateformes de collaboration d'entreprise est celle des Agents d'IA hyper-personnalisés qui s'adaptent aux utilisateurs individuels, aux cultures d'équipe et aux contextes organisationnels. C'est là que la recherche UX devient non seulement évaluative mais aussi générative, façonnant directement la conception et le déploiement de ces agents.

J'ai dirigé des initiatives de recherche qui informent le développement stratégique d'Agents d'IA personnalisés pour les plateformes de collaboration. Ce travail implique de comprendre les modèles spécifiques d'interaction des différents types d'utilisateurs avec l'IA, comment les styles de communication d'équipe varient selon les fonctions et les géographies, et comment la culture organisationnelle influence ce que les utilisateurs attendent de l'assistance IA.

Les recherches de McKinsey de novembre 2025 sur les partenariats IA notent que la réalisation du potentiel de l'IA nécessite de repenser les flux de travail pour que les personnes, les agents et les robots travaillent ensemble efficacement. Du point de vue de la stratégie produit, cela signifie que les Agents d'IA ne peuvent pas être universels. Ils doivent adapter leur style de communication, la fréquence d'intervention et le niveau d'autonomie en fonction des préférences des utilisateurs et des facteurs contextuels.

Ma recherche a identifié plusieurs dimensions de personnalisation qui comptent le plus dans les contextes de collaboration d'entreprise. L'adaptation du style de communication garantit que l'agent reflète la façon dont les utilisateurs s'expriment naturellement, qu'elle soit formelle ou décontractée, détaillée ou concise. Le calibrage du moment d'intervention apprend quand les utilisateurs individuels préfèrent une assistance proactive par rapport à quand ils veulent travailler sans interruption. L'ajustement du seuil de confiance reconnaît que différents utilisateurs ont différents niveaux de confort avec l'autonomie de l'IA et s'ajuste en conséquence.

Les implications stratégiques sont significatives. Les équipes produit qui construisent des Agents d'IA pour les plateformes de collaboration ont besoin d'un apport continu de recherche UX pour comprendre comment les fonctionnalités de personnalisation fonctionnent à travers diverses populations d'utilisateurs. Sans cette base de recherche, les efforts de personnalisation risquent de créer des agents qui semblent intrusifs pour certains utilisateurs tout en paraissant inutiles pour d'autres.

Un cadre pour évaluer les Agents d'IA dans des environnements collaboratifs

Grâce à des recherches approfondies sur le terrain avec des équipes interfonctionnelles adoptant des Agents d'IA dans leurs flux de travail collaboratifs, j'ai développé un cadre d'évaluation construit autour de quatre dimensions que les méthodes traditionnelles négligent.

- Impact de la présence examine comment la présence de l'Agent d'IA modifie le comportement de l'équipe, indépendamment de ses contributions fonctionnelles. J'ai observé que les équipes deviennent sensiblement plus formelles lorsqu'elles savent qu'une IA documente leurs conversations. Les discussions parallèles diminuent. La pensée exploratoire est remplacée par des contributions plus sûres.

- Limites d'agence aborde où l'autonomie de l'Agent d'IA devrait commencer et se terminer, et comment les équipes négocient ces limites. Les directives du Forum économique mondial de 2025 sur les Agents d'IA soulignent que la gouvernance doit promouvoir la transparence par une surveillance continue. Dans mes recherches, j'ai constaté que les préférences déclarées pour l'autonomie de l'IA correspondent rarement aux préférences révélées. Les équipes disent souvent qu'elles veulent que les Agents d'IA prennent plus d'initiatives, mais résistent lorsque les agents le font réellement.

- Calibrage de la confiance se concentre sur la façon dont les équipes développent une confiance appropriée, évitant à la fois la dépendance excessive et la sous-utilisation. Un Agent d'IA qui commet une erreur significative peut détruire des mois de construction de confiance, tandis qu'un agent qui fonctionne parfaitement peut créer une complaisance dangereuse.

- Intégration collaborative examine comment l'Agent d'IA affecte la dynamique d'équipe, le flux d'information et l'intelligence collective. L'Agent d'IA aide-t-il l'équipe à prendre de meilleures décisions, ou crée-t-il une illusion de rigueur masquant une pensée superficielle ?

Étude de cas : Reconfiguration de la portée de l'Agent d'IA

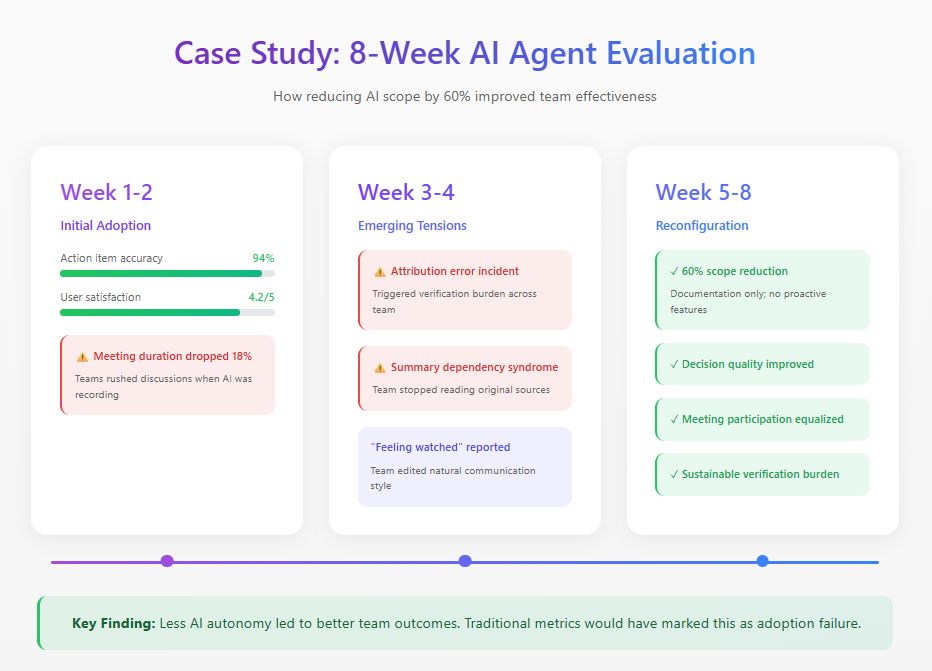

J'ai récemment mené une étude de huit semaines avec une équipe produit distribuée mettant en œuvre un Agent d'IA sur leur plateforme de collaboration. L'agent était conçu pour assister aux réunions, générer des résumés, suivre les décisions et présenter de manière proactive des informations pertinentes.

Les métriques initiales semblaient excellentes : 94% de précision des éléments d'action, 4,2 sur 5 pour les évaluations de satisfaction. Mais l'observation comportementale a révélé des problèmes invisibles sur les tableaux de bord. La durée des réunions a chuté de 18% car les membres de l'équipe précipitaient les discussions, conscients que chaque mot était capturé. À la troisième semaine, une erreur d'attribution a déclenché une charge de vérification qui a consommé plus de temps que la documentation qu'elle remplaçait. Les membres de l'équipe ont également développé ce que j'appelle le "syndrome de dépendance au résumé", s'appuyant exclusivement sur les résumés de l'IA et manquant un contexte crucial.

Sur la base de ces résultats, l'équipe a reconfiguré l'Agent d'IA, réduisant sa portée fonctionnelle de 60%. Ils ont supprimé les fonctionnalités proactives tout en conservant les tâches de documentation où la précision était élevée. Les métriques d'adoption traditionnelles marqueraient cela comme un échec. Mais les mesures d'efficacité de l'équipe ont raconté une histoire différente : la qualité des décisions s'est améliorée, la participation aux réunions est devenue plus équitable, et la charge de vérification a chuté à des niveaux durables.

La découverte la plus significative est ressortie des entretiens. Plusieurs membres de l'équipe ont décrit se sentir "surveillés" pendant la phase d'autonomie complète. Cet effet paralysant sur la communication authentique n'est jamais apparu dans aucune métrique de tableau de bord.

\

\

Méthodes d'évaluation pratiques

Sur la base de cette recherche et d'études similaires, je recommande les méthodes suivantes pour évaluer les Agents d'IA dans des environnements collaboratifs.

- Observation longitudinale nécessite des périodes d'observation minimales de six semaines avec établissement d'une base de référence avant l'introduction de l'Agent d'IA. Les tests d'utilisabilité en session unique ne révèlent presque rien d'utile sur la dynamique collaborative de l'IA.

- Analyse des modèles de communication implique le suivi quantitatif de qui parle, à quelle fréquence et dans quels contextes à travers les phases de pré-déploiement, de déploiement précoce et de déploiement mature.

- Évaluation du calibrage de la confiance mesure régulièrement comment la confiance des membres de l'équipe dans les capacités de l'IA se compare aux performances réelles de l'IA.

- Audits de qualité des décisions fournissent une analyse rétrospective des décisions prises avec l'implication de l'Agent d'IA, suivant les résultats et identifiant où la contribution de l'IA a aidé ou entravé.

La voie à suivre

Les Agents d'IA deviendront omniprésents dans la collaboration d'entreprise. La question de recherche n'est pas de savoir si les organisations les adopteront, mais comment elles les intégreront efficacement.

Les chercheurs UX ont un rôle crucial à jouer dans la formation de cette intégration. Nous possédons les méthodes pour comprendre le comportement humain et les cadres pour évaluer la qualité de l'expérience. Les organisations qui réussiront construiront des systèmes de collaboration où les humains et les Agents d'IA se complètent véritablement. Celles qui traitent les Agents d'IA comme une simple fonctionnalité découvriront que leurs équipes travaillent moins efficacement qu'avant l'arrivée de la technologie.

\

Vous aimerez peut-être aussi

Le support à 120 $ peut-il tenir bon ?

Groupe 360 : Les affirmations de Yu Hong concernant une « fraude financière » sont totalement contraires aux faits.