Weiterentwicklung von UX-Forschungsmethoden für KI-Agenten in der Unternehmenskooperation

\ Der Wandel geschah schneller als jeder vorhergesagt hatte. An einem Tag vervollständigte KI unsere Sätze. Am nächsten nahm sie an unseren Meetings teil, fasste unsere Gespräche zusammen und verfasste Folgenachrichten in unserem Namen. Jetzt trifft sie Entscheidungen.

Ich habe Jahre damit verbracht zu erforschen, wie Teams über intelligente Plattformen zusammenarbeiten, und was ich heute beobachte, stellt die bedeutendste Transformation der Arbeitsplatzdynamik seit der Einführung von E-Mail dar. AI Agents sind keine Werkzeuge mehr, die wir benutzen. Sie sind Teilnehmer, mit denen wir zusammenarbeiten.

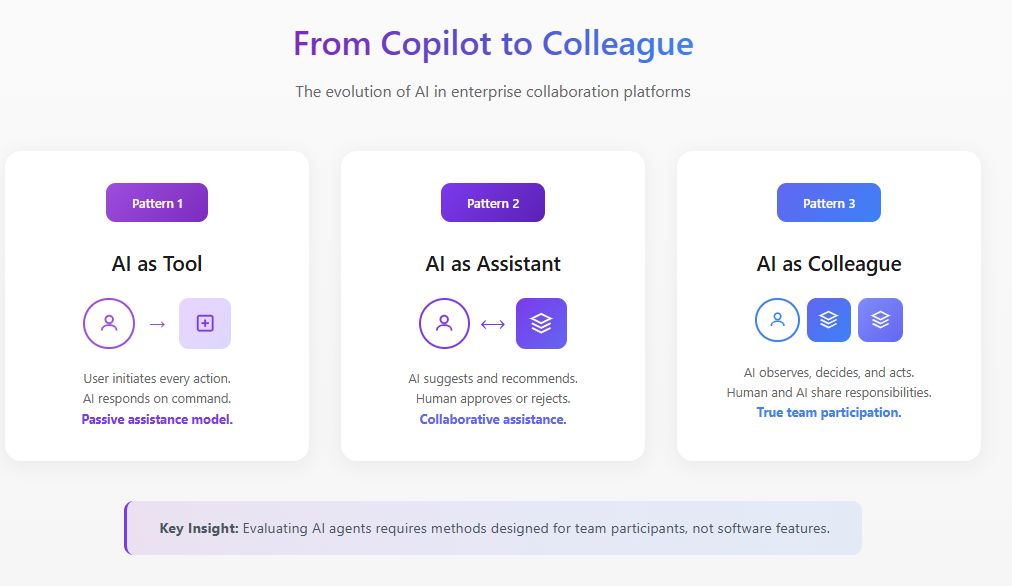

Dieser Unterschied ist für UX-Forscher enorm wichtig. Die Methoden, die wir zur Bewertung von Softwarefunktionen entwickelt haben, gelten einfach nicht mehr, wenn diese Software beginnt, sich wie ein Teammitglied zu verhalten.

Der grundlegende Wandel: Von der Funktion zum Teilnehmer

Traditionelle UX-Forschung stellt Fragen wie: Ist diese Funktion auffindbar? Ist die Interaktion intuitiv? Reduziert sie Reibung im Arbeitsablauf?

Diese Fragen gehen davon aus, dass die KI passiv ist und auf Benutzereingaben wartet, bevor sie reagiert. Aber AI Agents arbeiten anders. Sie beobachten, interpretieren, entscheiden und handeln. Laut der Forschung des MIT Sloan Management Review und der Boston Consulting Group von 2025 haben bereits 35% der Organisationen begonnen, agentische KI zu nutzen, wobei weitere 44% planen, sie bald einzuführen. Doch 47% geben an, dass sie keine Strategie dafür haben, was sie mit KI machen werden. Diese Lücke zwischen Einführung und Verständnis ist genau der Punkt, an dem die UX-Forschung eingreifen muss.

Wenn ein AI Agent einer Kollaborationsplattform beitritt, verändert er die soziale Dynamik des Teams. Er beeinflusst, wer spricht, wann gesprochen wird und was sich die Teilnehmer zu sagen trauen. Die Bewertung dieser Veränderungen erfordert Methoden, die weit über Usability-Tests hinausgehen.

\

Führende KI-Bewertung für Unternehmens-Kollaborationsplattformen

In meiner Arbeit als Leiter der UX-Forschung für intelligente Kollaborationsplattformen habe ich Bewertungsrahmen entwickelt, die speziell für AI Agents konzipiert sind, die in Unternehmensumgebungen arbeiten. Diese Arbeit befindet sich an der Schnittstelle von Produktstrategie, KI-Entwicklung und Forschung zu menschlichen Faktoren.

Die KI-Bewertung in diesem Kontext unterscheidet sich grundlegend vom traditionellen Modell-Benchmarking. Wenn ein AI Agent innerhalb einer Kollaborationsplattform arbeitet, können wir nicht einfach Genauigkeit oder Antwortqualität isoliert messen. Wir müssen bewerten, wie der Agent innerhalb der komplexen sozialen und operativen Dynamik echter Teams funktioniert.

Ich nähere mich KI-Bewertungen für Unternehmenskollaboration durch drei miteinander verbundene Schichten. Die erste Schicht untersucht die funktionale Leistung: Identifiziert der Agent Aktionspunkte korrekt, fasst er Diskussionen genau zusammen und liefert er relevante Informationen zu angemessenen Zeitpunkten? Die zweite Schicht bewertet die Integrationsqualität: Wie nahtlos arbeitet der Agent innerhalb bestehender Arbeitsabläufe, ohne Reibung zu erzeugen oder Verhaltensänderungen von Benutzern zu erfordern? Die dritte Schicht, und die am häufigsten übersehene, bewertet die systemische Auswirkung: Wie beeinflusst die Präsenz des Agenten die Teamdynamik, Entscheidungsqualität und kollaborative Effektivität im Laufe der Zeit?

Die Harvard Business Review-Forschung vom Mai 2025 beschreibt AI Agents als "digitale Teammitglieder", die eine aufkommende Kategorie von Talenten darstellen. Diese Rahmensetzung verlangt, dass wir AI Agents nicht nur nach Aufgabenerfüllung bewerten, sondern auch danach, wie gut sie als Teamteilnehmer funktionieren. Meine Bewertungsprotokolle beinhalten Verhaltensbeobachtung, Längsschnitterfassung und Ergebnisanalyse, die traditionelle KI-Benchmarks völlig übersehen.

Die Organisationen, die die stärksten Ergebnisse erzielen, sind diejenigen, die UX-Forschung direkt in ihre KI-Bewertungszyklen einbetten und menschenzentrierte Metriken neben technischen Leistungsmessungen verwenden.

\

Aufbau hyperpersonalisierter AI Agents durch strategische UX-Forschung

Die nächste Grenze für Unternehmens-Kollaborationsplattformen sind hyperpersonalisierte AI Agents, die sich an einzelne Benutzer, Teamkulturen und organisatorische Kontexte anpassen. Hier wird UX-Forschung nicht nur bewertend, sondern generativ, indem sie direkt beeinflusst, wie diese Agenten gestaltet und eingesetzt werden.

Ich leite Forschungsinitiativen, die die strategische Entwicklung personalisierter AI Agents für Kollaborationsplattformen informieren. Diese Arbeit umfasst das Verständnis der spezifischen Muster, wie verschiedene Benutzertypen mit KI interagieren, wie Teamkommunikationsstile über Funktionen und Geographien hinweg variieren und wie die Organisationskultur beeinflusst, was Benutzer von KI-Unterstützung erwarten.

McKinseys Forschung zu KI-Partnerschaften vom November 2025 stellt fest, dass die Realisierung des KI-Potenzials eine Neugestaltung der Arbeitsabläufe erfordert, damit Menschen, Agenten und Roboter effektiv zusammenarbeiten können. Aus Sicht der Produktstrategie bedeutet dies, dass AI Agents nicht nach dem Einheitsprinzip funktionieren können. Sie müssen ihren Kommunikationsstil, die Interventionshäufigkeit und den Grad der Autonomie basierend auf Benutzerpräferenzen und kontextuellen Faktoren anpassen.

Meine Forschung hat mehrere Personalisierungsdimensionen identifiziert, die im Kontext der Unternehmenskollaboration am wichtigsten sind. Die Anpassung des Kommunikationsstils stellt sicher, dass der Agent widerspiegelt, wie Benutzer sich natürlich ausdrücken, sei es formell oder lässig, detailliert oder prägnant. Die Kalibrierung des Interventionszeitpunkts lernt, wann einzelne Benutzer proaktive Unterstützung bevorzugen und wann sie ungestört arbeiten möchten. Die Anpassung der Vertrauensschwelle erkennt, dass verschiedene Benutzer unterschiedliche Komfortniveaus mit KI-Autonomie haben, und kalibriert entsprechend.

Die strategischen Implikationen sind bedeutend. Produktteams, die AI Agents für Kollaborationsplattformen entwickeln, benötigen kontinuierlichen UX-Forschungsinput, um zu verstehen, wie Personalisierungsfunktionen über verschiedene Benutzerpopulationen hinweg funktionieren. Ohne diese Forschungsgrundlage riskieren Personalisierungsbemühungen, Agenten zu schaffen, die für einige Benutzer aufdringlich wirken, während sie für andere nutzlos erscheinen.

Ein Rahmen zur Bewertung von AI Agents in kollaborativen Umgebungen

Durch umfangreiche Feldforschung mit funktionsübergreifenden Teams, die AI Agents in ihren Kollaborationsabläufen einsetzen, habe ich einen Bewertungsrahmen entwickelt, der auf vier Dimensionen basiert, die traditionelle Methoden übersehen.

- Präsenzwirkung untersucht, wie die Präsenz des AI Agents das Teamverhalten verändert, unabhängig von seinen funktionalen Beiträgen. Ich habe beobachtet, dass Teams messbar formeller werden, wenn sie wissen, dass eine KI ihre Gespräche dokumentiert. Nebengespräche nehmen ab. Exploratives Denken wird durch sicherere Beiträge ersetzt.

- Handlungsgrenzen befasst sich damit, wo die Autonomie des AI Agents beginnen und enden sollte und wie Teams diese Grenzen aushandeln. Die Leitlinien des Weltwirtschaftsforums 2025 zu AI Agents betonen, dass Governance Transparenz durch kontinuierliche Überwachung fördern muss. In meiner Forschung habe ich festgestellt, dass erklärte Präferenzen für KI-Autonomie selten mit offenbarten Präferenzen übereinstimmen. Teams sagen oft, dass sie möchten, dass AI Agents mehr Initiative ergreifen, widerstehen aber, wenn Agenten dies tatsächlich tun.

- Vertrauenskalibrierung konzentriert sich darauf, wie Teams angemessenes Vertrauen entwickeln und dabei sowohl übermäßige Abhängigkeit als auch Unternutzung vermeiden. Ein AI Agent, der einen bedeutenden Fehler macht, kann monatelange Vertrauensbildung zerstören, während ein Agent, der perfekt funktioniert, gefährliche Selbstzufriedenheit erzeugen kann.

- Kollaborative Integration untersucht, wie der AI Agent die Teamdynamik, den Informationsfluss und die kollektive Intelligenz beeinflusst. Hilft der AI Agent dem Team, bessere Entscheidungen zu treffen, oder schafft er eine Illusion von Gründlichkeit, die oberflächliches Denken verbirgt?

Fallstudie: Neukonfiguration des AI Agent-Umfangs

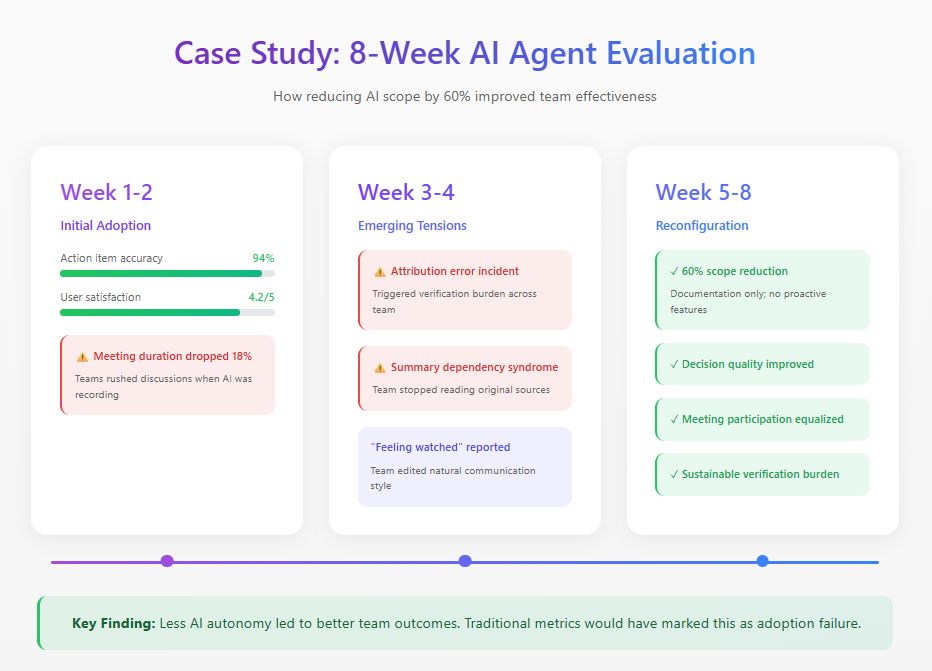

Kürzlich führte ich eine achtwöchige Studie mit einem verteilten Produktteam durch, das einen AI Agent auf ihrer Kollaborationsplattform implementierte. Der Agent wurde entwickelt, um an Meetings teilzunehmen, Zusammenfassungen zu erstellen, Entscheidungen zu verfolgen und proaktiv relevante Informationen zu liefern.

Die anfänglichen Metriken sahen hervorragend aus: 94% Genauigkeit bei Aktionspunkten, 4,2 von 5 Zufriedenheitsbewertungen. Aber die Verhaltensbeobachtung offenbarte Probleme, die für Dashboards unsichtbar waren. Die Meetingdauer sank um 18%, da Teammitglieder Diskussionen beschleunigten, im Bewusstsein, dass jedes Wort erfasst wurde. In der dritten Woche löste ein Zuordnungsfehler eine Verifizierungslast aus, die mehr Zeit in Anspruch nahm als die Dokumentation, die sie ersetzte. Teammitglieder entwickelten auch, was ich "Zusammenfassungsabhängigkeitssyndrom" nenne, indem sie sich ausschließlich auf KI-Zusammenfassungen verließen und entscheidenden Kontext verpassten.

Basierend auf diesen Erkenntnissen konfigurierte das Team den AI Agent neu und reduzierte seinen funktionalen Umfang um 60%. Sie entfernten proaktive Funktionen, behielten aber Dokumentationsaufgaben bei, bei denen die Genauigkeit hoch war. Traditionelle Adoptionsmetriken würden dies als Misserfolg kennzeichnen. Aber Teameffektivitätsmaßnahmen erzählten eine andere Geschichte: Die Entscheidungsqualität verbesserte sich, die Meetingteilnahme wurde gerechter und die Verifizierungslast sank auf nachhaltige Niveaus.

Die bedeutendste Erkenntnis ergab sich aus Interviews. Mehrere Teammitglieder beschrieben, dass sie sich während der Phase voller Autonomie "beobachtet" fühlten. Dieser abschreckende Effekt auf authentische Kommunikation erschien nie in irgendeiner Dashboard-Metrik.

\

\

Praktische Bewertungsmethoden

Basierend auf dieser Forschung und ähnlichen Studien empfehle ich die folgenden Methoden zur Bewertung von AI Agents in kollaborativen Umgebungen.

- Längsschnittbeobachtung erfordert mindestens sechswöchige Beobachtungszeiträume mit Basislinienermittlung vor der Einführung des AI Agents. Einzelsitzungs-Usability-Tests offenbaren fast nichts Nützliches über kollaborative KI-Dynamiken.

- Kommunikationsmusteranalyse beinhaltet quantitatives Tracking, wer spricht, wie oft und in welchen Kontexten über die Phasen vor der Bereitstellung, frühe Bereitstellung und reife Bereitstellung hinweg.

- Vertrauenskalibrierungsbewertung misst regelmäßig, wie das Vertrauen der Teammitglieder in KI-Fähigkeiten mit der tatsächlichen KI-Leistung verglichen wird.

- Entscheidungsqualitätsprüfungen bieten retrospektive Analysen von Entscheidungen, die mit Beteiligung des AI Agents getroffen wurden, verfolgen Ergebnisse und identifizieren, wo der KI-Beitrag geholfen oder behindert hat.

Der Weg nach vorn

AI Agents werden in der Unternehmenskollaboration allgegenwärtig werden. Die Forschungsfrage ist nicht, ob Organisationen sie einführen werden, sondern wie sie sie effektiv integrieren werden.

UX-Forscher haben eine entscheidende Rolle bei der Gestaltung dieser Integration. Wir verfügen über die Methoden, um menschliches Verhalten zu verstehen, und die Rahmenwerke, um Erfahrungsqualität zu bewerten. Die Organisationen, die dies richtig machen, werden Kollaborationssysteme aufbauen, in denen Menschen und AI Agents sich wirklich ergänzen. Diejenigen, die AI Agents nur als eine weitere Funktion behandeln, werden feststellen, dass ihre Teams weniger effektiv arbeiten als vor der Ankunft der Technologie.

\

Das könnte Ihnen auch gefallen

Politischer Einfluss auf Zinsen sorgt für Unruhe

Stichwunden an den Leichen: Polizei nimmt Sohn von getötetem US-Regisseur Reiner fest